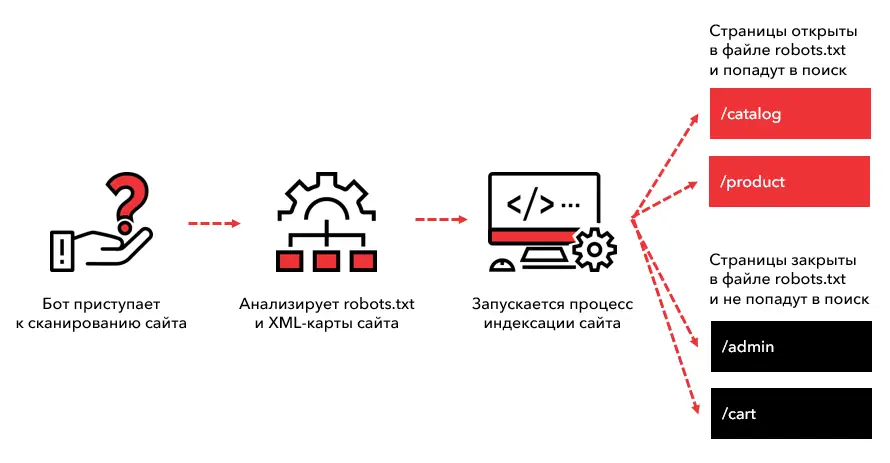

Файл robots.txt является одним из важных элементов каждого веб-сайта. Он предназначен для управления поведением поисковых роботов, указывая, какие страницы или разделы сайта должны быть проиндексированы, а какие — нет. Однако, несмотря на свою простоту, создание правильного файла robots.txt может быть непростой задачей. В этой статье мы рассмотрим 7 распространенных ошибок, которые часто допускаются при его создании.

Первая ошибка — ошибка в синтаксисе. Файл robots.txt должен быть написан в определенном формате, и даже небольшая ошибка в синтаксисе может привести к неправильной интерпретации файла поисковыми роботами. Поэтому перед публикацией файла на сайте следует проверить его на наличие ошибок.

Вторая ошибка — неправильное указание директивы «User-agent». User-agent указывает на поискового робота, к которому применяются следующие после него правила. Ошибка может заключаться в указании несуществующего либо устаревшего User-agent, а также в неправильной записи его названия.

Третья ошибка — неправильное указание директивы «Disallow». Директива «Disallow» указывает на страницы, которые не должны быть проиндексированы поисковыми роботами. Ошибка может заключаться в указании неправильного пути к странице, либо в указании пути к несуществующей странице. Также можно допустить ошибку, указав «Disallow: /», что означает запрет на индексацию всего сайта.

Четвертая ошибка — неправильное указание директивы «Allow». Директива «Allow» указывает на страницы, которые разрешено индексировать поисковым роботам, даже если предыдущие директивы запрещают индексацию всего сайта или его определенных разделов. Ошибка может заключаться в неправильной записи Allow-правил или в неправильно указанном пути к разрешенным страницам.

Пятая ошибка — отсутствие файла robots.txt. Некоторые веб-мастера забывают создать файл robots.txt или случайно его удаляют. В результате поисковые роботы получают полный доступ к всем страницам сайта, что может привести к нежелательным последствиям, таким как индексация чувствительной информации.

Шестая ошибка — неправильное размещение файла robots.txt. Файл robots.txt должен быть размещен в корневой директории сайта. Если файл размещен в другом месте, поисковые роботы не смогут его обнаружить, и все страницы сайта будут проиндексированы по умолчанию.

Седьмая ошибка — отсутствие обновлений файла robots.txt. Сайты постоянно меняются, и страницы, которые раньше должны были быть запрещены для индексации, могут стать открытыми для поисковых роботов. Поэтому рекомендуется регулярно проверять и обновлять файл robots.txt, чтобы учесть все изменения на сайте.

Неправильное размещение файла robots.txt

Ошибкой может быть размещение файла robots.txt в неправильном каталоге на сервере. Чтобы поисковые роботы смогли найти и прочитать файл, он должен быть размещен в корневом каталоге вашего сайта. В противном случае, поисковые системы могут не обнаружить файл и продолжат индексацию в соответствии с настройками по умолчанию.

Еще одна распространенная ошибка — открытое размещение файла robots.txt. Если файл находится в корневом каталоге и доступен для всех, злоумышленники могут использовать информацию, содержащуюся в файле, для получения доступа к ограниченным страницам вашего сайта. Таким образом, важно убедиться, что файл доступен только для чтения и недоступен для изменения или удаления.

- Правильное размещение файла robots.txt: Файл robots.txt должен быть размещен в корневом каталоге вашего сайта.

- Защита доступа к файлу: Убедитесь, что файл доступен только для чтения и недоступен для изменения или удаления.

Неправильное написание синтаксиса

Одна из таких ошибок — это неправильное использование директив. Каждая директива должна начинаться с символа «/» и предшествовать её должен символ «*» или «$». Например, если вы хотите запретить индексацию всего сайта, то нужно использовать директиву Disallow: /. Если же вы хотите запретить индексацию только определенной страницы, то нужно указать её URL после символа «/».

- Неправильное использование директивы может привести к тому, что поисковые роботы будут проиндексировать страницы, которые вы хотели исключить из индексации.

- Также стоит обратить внимание на правило использования символов «*», «$» и «=». Например, символ «*» означает, что последующая часть URL является шаблоном и может быть заменена на любую последовательность символов. Символ «$» используется для указания конца URL. Например, директива Disallow: /my-page$ запретит индексацию только страницы с URL «/my-page», но не запретит индексацию страницы с URL «/my-page/sub-page».

Кроме того, установка неправильных правил доступа также может привести к некорректной работе файла robots.txt. Например, некоторые поисковые роботы могут не поддерживать определенные директивы или символы, поэтому следует быть внимательными при использовании всех возможностей файла robots.txt.

Отсутствие проверки работоспособности файла

Для того чтобы избежать этой ошибки и убедиться в правильности работы файла robots.txt, следует использовать специальные инструменты для проверки конфигурации файла. Благодаря этим инструментам вы сможете увидеть, как файл воспринимается поисковыми роботами, и внести необходимые изменения, если потребуется.

Важно помнить, что проверка работоспособности файла robots.txt является неотъемлемой частью создания эффективного и корректного файла. Игнорирование этого шага может привести к нежелательным последствиям, таким как блокировка поисковых систем или индексация нежелательных страниц.

Наши партнеры: